标注

pandas

定位

web3

css3

php

华为机试

nlp

random

关键路径

雨滴传感器

框架

selenium

mvc

批量

AI二次开发

基础语法

普林斯顿大学

ubuntu-18.04

sass

elmo

2024/4/21 21:09:16看了这篇你还不懂BERT,那你就过来打死我吧

目录

1. Word Embedding. 1

1.1 基于共现矩阵的词向量... 1

1.2 基于语言模型的词向量... 2

2. RNN/LSTM/GRU.. 5

2.1 RNN.. 5

2.2 LSTM 通过门的机制来避免梯度消失... 6

2.3 GRU 把遗忘门和输入门合并成一个更新门... 6

3. seq2seq模型... 8

3.1 朴素的seq2seq模型.…

【AI理论学习】语言模型:掌握BERT和GPT模型

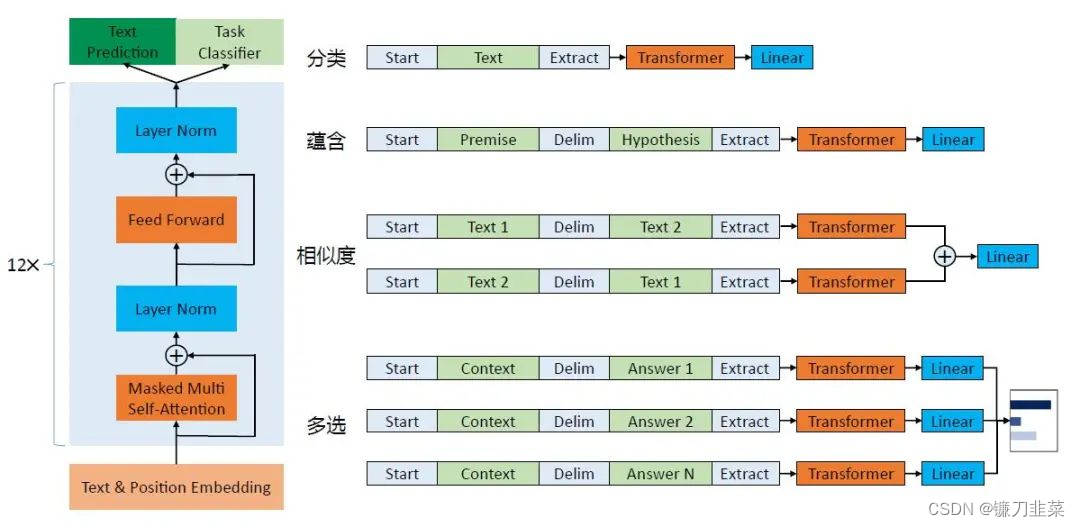

语言模型:掌握BERT和GPT模型 BERT模型BERT的基本原理BERT的整体架构BERT的输入BERT的输出 BERT的预训练掩码语言模型预测下一个句子 BERT的微调BERT的特征提取使用PyTorch实现BERT GPT模型GPT模型的整体架构GPT的模型结构GPT-2的Multi-Head与BERT的Multi-Head之间的…

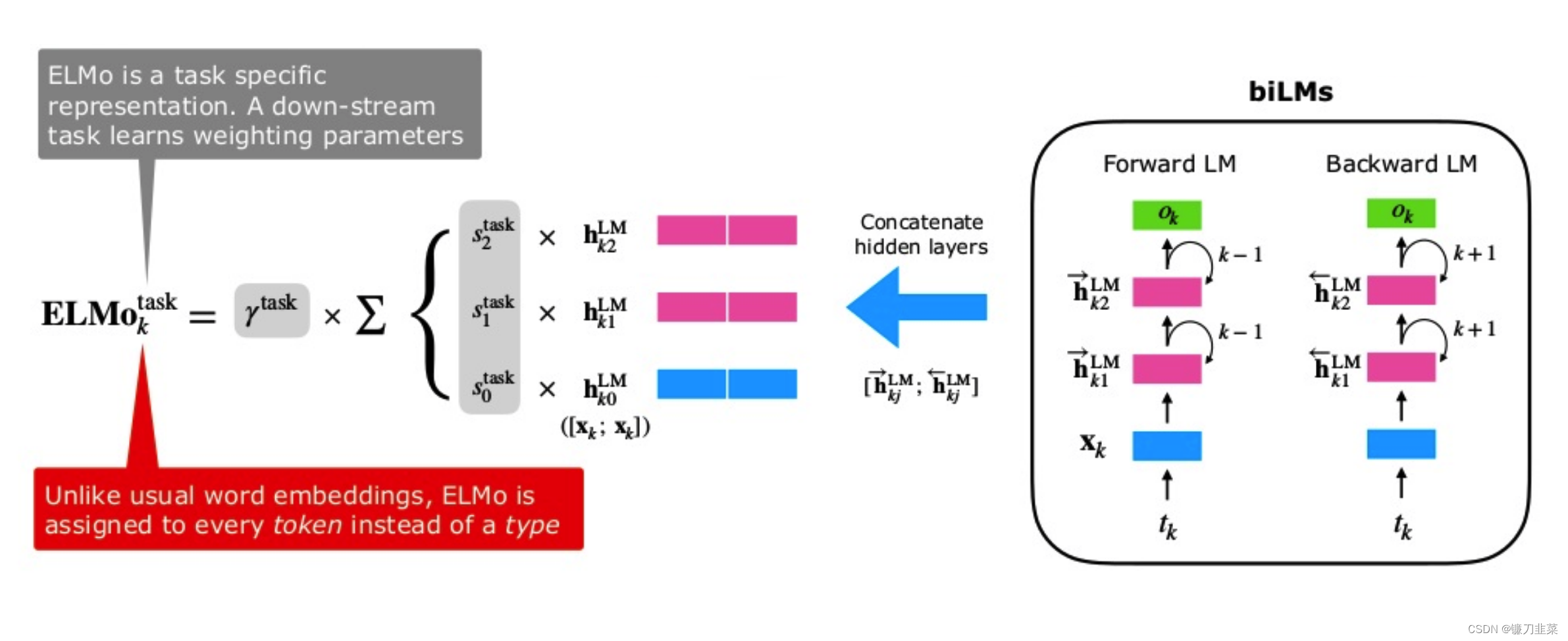

【AI理论学习】语言模型:从Word Embedding到ELMo

语言模型:从Word Embedding到ELMo ELMo原理Bi-LM总结参考资料 本文主要介绍一种建立在LSTM基础上的ELMo预训练模型。2013年的Word2Vec及2014年的GloVe的工作中,每个词对应一个vector,对于多义词无能为力。ELMo的工作对于此,提出了…

『NLP学习笔记』图解 BERT、ELMo和GPT(NLP如何破解迁移学习)

图解 BERT、ELMo和GPT(NLP如何破解迁移学习) 文章目录 一. 前言二. 示例-句子分类三. 模型架构3.1. 模型输入3.2. 模型输出四. BERT VS卷积神经网络五. 词嵌入新时代5.1. 简要回顾词嵌入Word Embedding5.2. ELMo: 上下文语境很重要5.3. ELMo的秘密是什么?5.4. ULM-FiT:将迁移…